Технический SEO аудит

Требования к файлу Robots.txt

Robots.txt - это файл с инструкцией для роботов поисковых систем, он должен присутствовать на сайте (загружается в корень сайта). Данный текстовый файл должен называться именно так: robots.txt, и после загрузки в корень сайта должен быть доступен по адресу https://site.ru/robots.txt, где https://site.ru/ - название домена.

Robots.txt может содержать в себе инструкции для любого из поисковых роботов по отдельности. Это делается с помощью директивы User-Agent. Символ * означает, что директивы предназначены для всех поисковых роботов. С директивы User-Agent должны начинаться инструкции для поискового робота.

Host - это директива, воспринимаемая исключительно поисковым роботом Яндекса, указывает роботу на основное зеркало сайта. На сегодняшний день данную директиву прописывать не нужно, поскольку ее полностью заменил редирект 301.

Директива Sitemap указывает поисковому роботу на адрес карты сайта в формате .xml.

Основной директивой является Disallow. Данная директива запрещает поисковым роботам индексировать мусорные страницы, страницы фильтрации, сортировки, служебные страницы и т.д. (все они должны быть закрыты от индексации).

Директивы пишутся для сайта индивидуально после окончания его разработки.

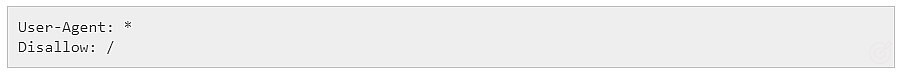

Во время разработки сайт должен быть закрыт от индексации, следовательно, файл robots.txt должен иметь следующее содержимое:

Ссылки на документацию:

- Яндекс

- Инструмент проверки robots.txt webmaster.yandex.ru/tools/robotstxt/

Требования к файлу sitemap.xml

Карта сайта в формате .xml (файл sitemap.xml) должна быть расположена в корневой папке сайта и содержать в себе перечень всех его страниц. Если сайт включает в себя более 20 тысяч страниц, создается несколько карт в формате .xml, ссылки на которые содержатся в файле индекса sitemap.

- Описание стандарта

- Описание от Яндекс

- Описание от Google

Технический аудит

SEO-аудит можно разделить на две основные составляющие: проверка качества внутренней оптимизации и аудит тех. параметров сайта.

Без проведения SEO-аудита, даже в случае реализации грамотной структуры сайта и размещения качественного контента на основании собранного семантического ядра, есть риск заметно снизить рост позиций/трафика, а в некоторых случаях - полностью исключить возможность достижения результата.

Важно понимать, что целью SEO-аудита является не просто выявление проблем, но и создание максимально однозначных и развернутых рекомендаций по их устранению.

Работа с программами для анализа сайтов

Для расширенного технического аудита рекомендуется установить программу Screaming Frog SEO Spider или ее аналоги (например, Netpeak SEO Spider). Все действия будут показаны именно в программе Screaming Frog.

Настройка программы

Основные

Чтобы открыть настройки программы, необходимо перейти на пункт Configuration ⇒ Spider и далее провести настройки по вкладкам.

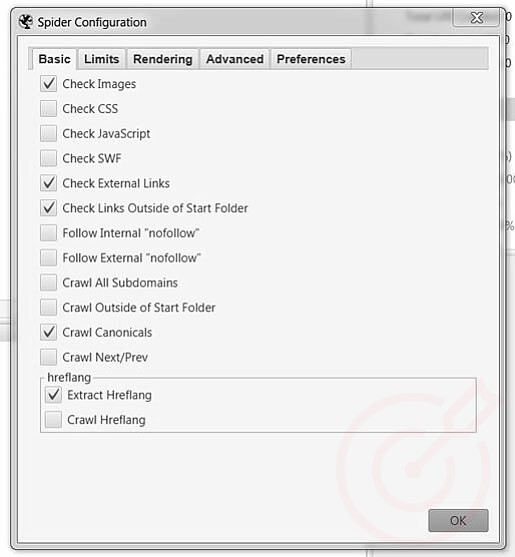

На основной вкладке (Basic) необходимо отключить то, что может затянуть процесс сканирования. В первую очередь это:

- CSS-стили

- JavaScript

- SWF

В некоторых случаях можно также отключать изображения. Однако, как правило, их также нужно сканировать, чтобы понимать, какой размер у изображений, а также у всех ли изображений прописаны необходимые HTML-теги.

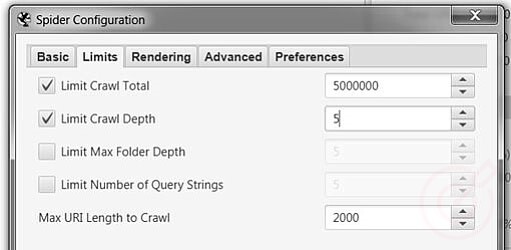

После основных настроек переходим к лимитам (limits). В 99% случаев на этой вкладке не нужно вносить изменений. Однако если вы анализируете очень большой проект и его сканирование занимает слишком много времени (например, больше суток), можно воспользоваться пунктом Limit Search Depth, который позволяет ограничить сканирование по вложенности страницы.

С помощью этого пункта можно запретить программе сканировать страницы сайта, которые находятся дальше чем, скажем, 5 уровень вложенности. Это заметно сэкономит время.

Далее необходимо переместиться на вкладку Advanced. Здесь есть две интересные вкладки:

- Respect noindex

- Respect canonical

Если они включены, в результаты сканирования не будут попадать закрытые от индекса страницы (в том числе и через мета-тег robots), а также неканоничные страницы. Это позволит сократить время на анализ сайта. Однако включив их, мы можем не увидеть страницы, которые закрыты от индекса по ошибке, либо те, которые ошибочно считаются неканоничными.

По умолчанию включать эти опции мы не рекомендуем.

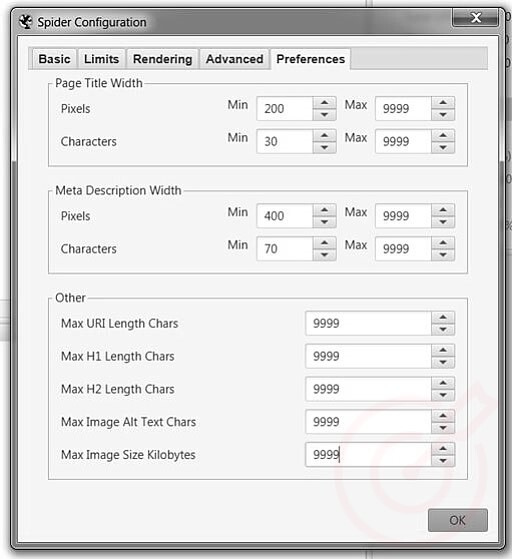

С помощью вкладки Preferences можно задать размеры мета-тегов, url, заголовков h1-h2 и других параметров. Чтобы ничего не упустить, по умолчанию рекомендуется указать максимальные значения:

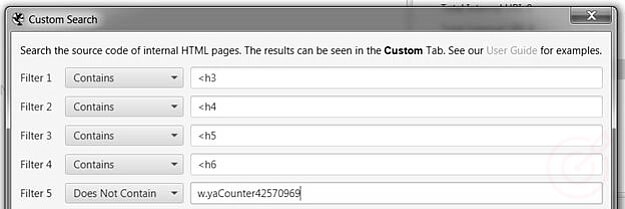

По умолчанию программа сканирует только заголовки в тегах h1 и h2. Но нам также необходимо знать, на каких страницах находятся теги h3-h6. Сканирование этих подзаголовков необходимо задавать вручную. Чтобы это сделать, перейдите в пункт Configuration ⇒ Custom ⇒ Search и укажите, что конкретно требуется найти на страницах сайта. В нашем случае это заголовки h3-h6:

Обратите внимание, что таким способом можно искать абсолютно любую информацию на сайте. Например, если вы хотите узнать, на каких страницах встречается слово «SEO», то в поле выше необходимо вписать именно его.

Бывает другая ситуация, когда необходимо найти, на каких страницах отсутствует та или иная информация.

Например, вы хотите узнать, на каких страницах отсутствует код Яндекс.Метрики. Перейдите в пункт Configuration ⇒ Custom ⇒ Search. Выберите в фильтре Does Not Contain и введите id счетчика Яндекс.Метрики:

Программа выдаст все страницы, на которых отсутствует Яндекс.Метрика.

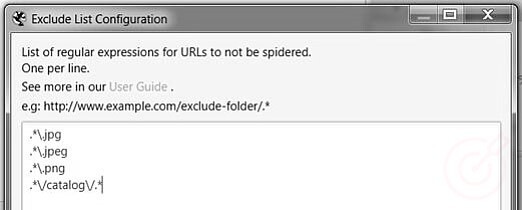

Сканирование определенных папок и каталогов

Если вы не хотите сканировать определенные страницы (например, содержащие в url слово catalog), то необходимо задать их с помощью регулярных выражений. Для этого перейдите в пункт Configuration ⇒ Exclude и задайте нужные значения:

Например, на скрине выше запрещено сканирование изображений в формате .jpg, .jpeg, .png, а также страниц, в url которых встречается слово «catalog».

Если вы хотите найти только те страницы, которые включают определенный маркер, необходимо воспользоваться пунктом Include.

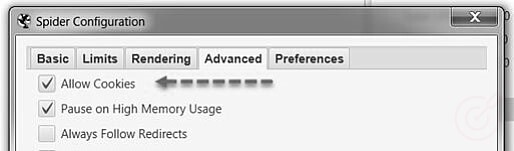

Сканирование сайтов, требующих cookies

Если при сканировании сайта требуется разрешить cookies, для этого необходимо поставить галочку в пункте Allow Cookies в меню Configuration и вкладке Advanced:

Что делать, если при сканировании возникает ошибка?

Иногда случается так, что при сканировании сайта страницы начинают отдавать различные ошибки, и невозможно получить нужную информацию.

В таком случае можно сделать несколько вещей:

- Уменьшить количество потоков и скорость парсинга.

- Использовать прокси.

- Обратиться к сайту как робот одной из поисковых систем.

Рассмотрим каждый из этих пунктов подробнее.

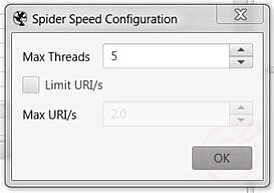

Уменьшение скорости парсинга и количества потоков

Сделать это можно, зайдя в пункт меню Configuration и выбрав раздел Speed:

В первом поле нужно указать количество потоков. Если возникает такая же ошибка, как на скрине выше, рекомендуется установить количество потоков 2-3.

Если включить опцию Limit URL/s, то можно установить ограничение на количество сканируемых страниц в секунду. При возникновении ошибок рекомендуется выставить скорость 1-2 страницы в секунду.

Использование прокси

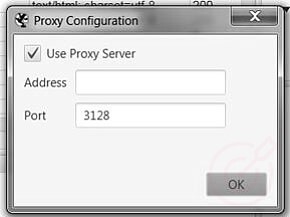

Чтобы обойти защиту от парсинга, можно включить прокси. Для этого в меню выберите Configuration ⇒ System ⇒ Proxy:

В этом окне необходимо ввести адрес прокси-сервера. Прокси есть как платные, так и бесплатные. Хороший сайт по продаже платных прокси - https://primeproxy.net

Обращение к сайту как робот поисковой системы

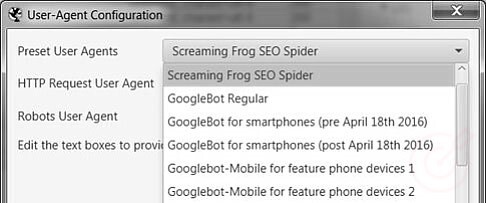

Screaming Frog предоставляет возможность выбрать бота, от имени которого программа будет обращаться к сайту. По умолчанию это делается стандартным ботом программы, в результате чего попытка просканировать сайт нередко блокируется.

Чтобы выбрать другого бота, нужно выбрать в меню Configuration ⇒ User Agent. В выпадающей вкладке выберите нужного робота (рекомендуем выбирать робота Яндекс или Google):

Обычно после всех этих действий ошибок не возникает.

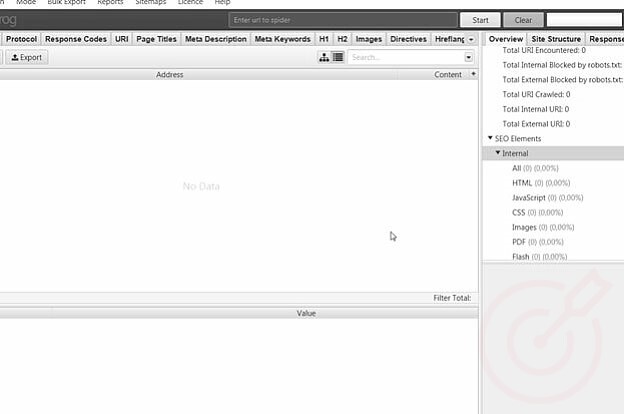

Как начать сканирование?

Чтобы начать сканирование, добавьте адрес сайта в программу и нажмите Start:

Для остановки сканирования нажмите кнопку Stop (позже можно возобновить сканирование), а для очистки результатов нажмите кнопку Clear.

Если вы хотите получить информацию только по определенным страницам, которые уже у вас есть, то необходимо изменить режим загрузки урлов. Для этого нажмите на пункт Mode и выберите режим List. После этого вы можете загрузить нужные урлы:

Поиск ошибок

Как найти неработающие и перенаправляющие ссылки?

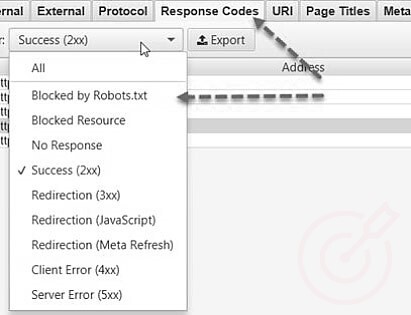

Все страницы, участвующие во внутренней линковке сайта (проще говоря, все страницы сайта, которые фактически имеются), должны отдавать код 200 OK. Как найти страницы с кодом ответа, отличного от 200?

После сканирования сайта перейдите на вкладку Response Codes и с помощью фильтра найдите нужные ошибки. Вы увидите:

- Закрытые от индексации в Robots.txt.

- Заблокированные ресурсы.

- Без кода ответа.

- С кодом ответа 2хх.

- С кодом ответа 3хх.

- С редиректом (перенаправлением), через JavaScript.

- С редиректом (перенаправлением), через Meta Refresh.

- С кодом ответа 4хх.

- С кодом ответа 5хх.

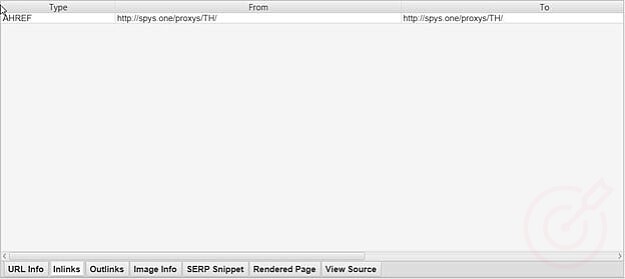

При нажатии на отдельный URL в результате сканирования в нижней части окна вы увидите информацию. Если нажать на In Links, можно увидеть список страниц, которые ссылаются на выбранный URL, а также посмотреть информацию по анкорам на этих страницах. Так можно легко найти источник проблемы:

Как найти проблемы с url’ами?

Адреса страниц сайта после доменного имени должны содержать только строчные латинские буквы, цифры, дефис (символ «-») и, разумеется, символ «/» в качестве разделителя или окончания URL.

Пример корректного url:

https://site.ru/tovarnaya-kategoriya/tovarnaya-podkategoriya/

Примеры некорректных url’ов:

https://site.ru/Tovarnaya_kategoriya/Tovarnaya_podkategoriya/

https://site.ru/Tovarnaya_kategoriya/товарная_подкатегория/ и т.д.

Разумеется, вышеописанные требования не распространяются на параметрические приписки к url’ам вида ?sort=price

Т.е. динамические генерирующиеся страницы вида:

https://site.ru/tovarnaya-kategoriya/?page=1

или

https://site.ru/tovarnaya-kategoriya/?sort=price

не являются отдельными страницами и могут иметь такие параметрические приписки.

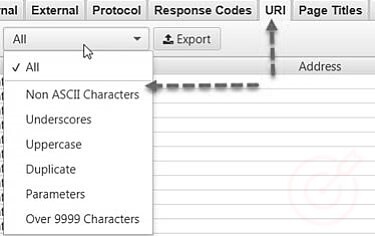

Найти все отклонения от стандартов можно на вкладке url. Здесь находится:

- Страницы, не использующие ЧПУ.

- Страницы с подчеркиванием (_) в url.

- Страницы с верхним регистром в url.

- Дубли страниц.

- Параметрические урлы (со спецсимволами, например, со знаком вопроса).

- Слишком длинные урлы.

Опять же, нажатием на In Links можно отследить, какие страницы ссылаются на проблемный url.

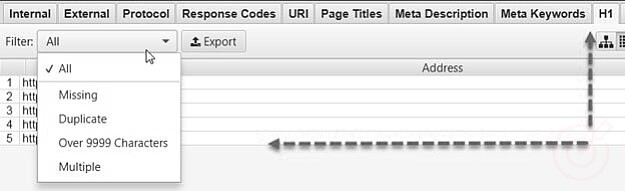

Как найти проблемы с Title?

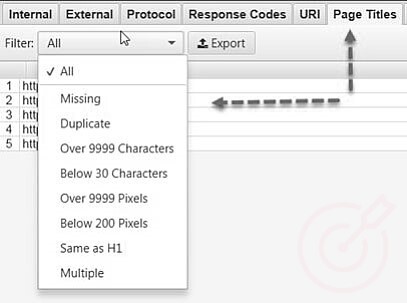

На соответствующей вкладке можно отследить основные проблемы с Title:

Программа вам покажет страницы, на которых:

- title отсутствует,

- title дублируется,

- title слишком большой,

- title слишком маленький,

- title совпадает с h1,

- title встречается больше одного раза.

Таким образом, можно легко найти проблемные страницы и исправить их.

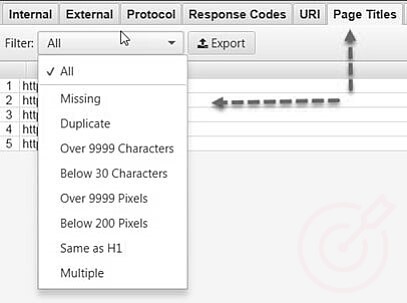

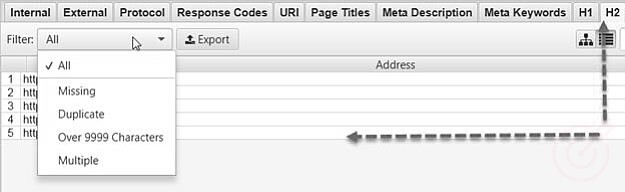

Как найти проблемы с Description?

На соответствующей вкладке можно отследить основные проблемы с Description:

Программа покажет страницы, на которых:

- description отсутствует,

- description дублируется,

- description слишком большой,

- description слишком маленький,

- description встречается больше одного раза.

Таким образом, можно легко найти проблемные страницы и исправить их.

Как найти проблемы с заголовками в теге h1?

На каждой странице сайта должен быть ровно один заголовок в теге 'h1''/h1'.

Требования к заголовку h1:

- Должен быть текстовым элементом. В теге h1 должен содержаться исключительно текст.

- Должен быть расположен в верхней части страницы над основным контентом.

- Должен отражать суть страницы.

- Должен быть уникальным для каждой страницы (разумеется, динамические генерирующиеся страницы вида https://site.ru/tovarnaya-kategoriya/?page=1 или https://site.ru/tovarnaya-kategoriya/?sort=price не являются отдельными страницами и о них речи не идет. Их заголовок в теге h1 должен быть таким же, как у страницы https://site.ru/tovarnaya-kategoriya/)

- Должен быть корректным с точки зрения русского или другого языка.

- Не должен являться ссылкой или чем-либо еще, что отлично от простого текста.

- Не должен быть написан целиком прописными (большими) буквами.

С помощью вкладки h1 можно найти все проблемы, которые могут возникнуть с данным тегом:

Программа покажет страницы, где:

- h1 отсутствует,

- h1 дублируется,

- h1 слишком большой,

- h1 используется больше одного раза.

Таким образом, можно легко найти проблемные страницы и исправить их.

Как найти заголовки в теге h2?

Аналогичная ситуация с h2:

Программа покажет страницы, где:

- h2 отсутствует,

- h2 дублируется,

- h2 слишком большой,

- h2 используется больше двух раз.

Кроме того, вы сможете понять, где h2 используется не по назначению (не в тексте).

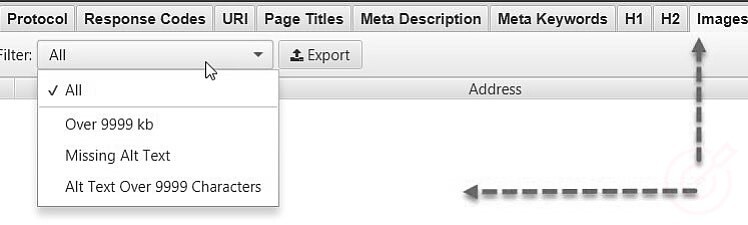

Как найти проблемы с изображениями?

С помощью Screaming Frog можно найти:

- Слишком большие изображения.

- Изображения, на которых отсутствует тег ALT.

- Изображения, у которых слишком большое содержимое в теге ALT.

Все это можно узнать на вкладке Images:

Нажав на вкладку Image Info в нижнем окне, вы найдете все страницы, на которых размещаются хотя бы какие-нибудь изображения. Страницы будут перечислены в столбце From.

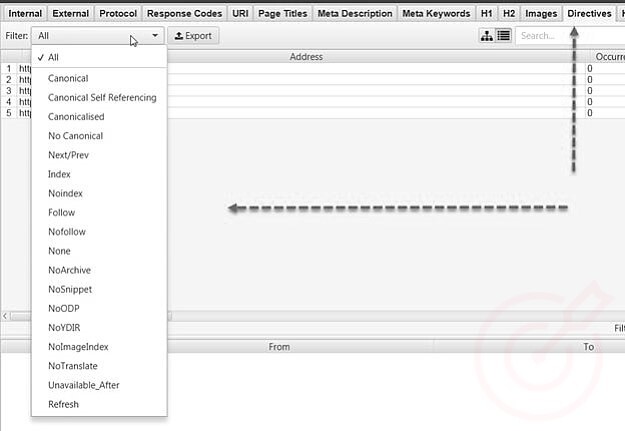

Как найти URL, содержащие мета-директивы?

Для этого следует перейти в раздел Directives. На этой вкладке пользователю предоставляется следующая информация:

Наиболее часто приходится пользоваться следующими пунктами:

- Canonical.

- No canonical.

- Index.

- Noindex.

- Follow.

- Nofollow.

Например, с помощью фильтра Noindex можно найти страницы, которые по ошибке закрыты от индексации и недополучают трафик.

Как найти страницы с неинформативным или отсутствующим контентом?

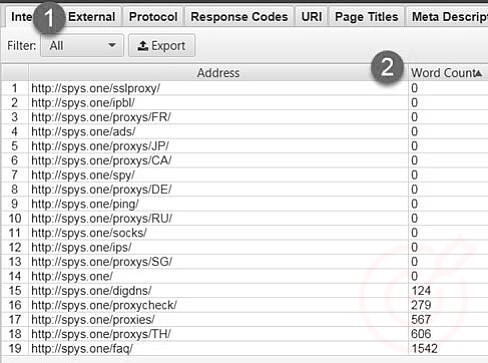

После сканирования сайта на вкладке Internal задайте фильтрацию по HTML и прокрутите содержимое вправо, до столбца Word Count.

Здесь необходимо отсортировать содержимое страниц от меньшего к большему, так станет ясно, на каких страницах текст отсутствует или неинформативен.

Кроме этого, можно перетащить столбец Word Count влево и поместить рядом с урлами, чтобы сделать информацию более наглядной.

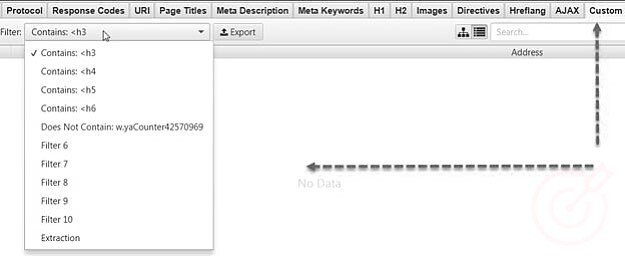

Как найти страницы, где используются теги h3-h6?

Сканирование этих тегов необходимо задавать вручную, выше уже было описано, как это делается. Результат сканирования можно посмотреть на вкладке Custom. С помощью фильтра можно отсортировать результаты по нужным значениям:

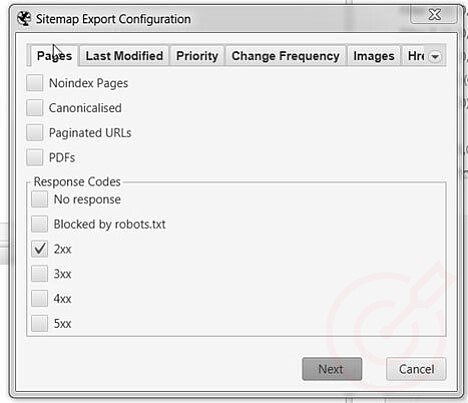

Как создать карту сайта в формате .xml

С помощью программы Screaming Frog SEO Spider можно легко создать файл sitemap.xml. После сканирования сайта необходимо нажать на вкладку Sitemap и выбрать пункт Create XML Sitemap, появится окно со следующими настройками:

По умолчанию здесь все настроено верно. Можно сразу нажать кнопку Next и выбрать, куда сохранить созданную карту.

Можно поиграть с настройками, добавив в карту страницы, например, закрытые от индекса. Но в 99% случаев это не нужно.

Чек-лист SEO аудита

Чек-лист SEO аудита выглядит примерно следующим образом:

- Надежный хостинг (выделенный ли сервер, нормально ли работает сайт, вдруг он грузится часами при нормальном коде).

- Скорость работы сайта (если код нормальный, а сайт грузится часами, проблема в оптимизации работы CMS).

- Аптайм сайта (проверяется в метрике: отчеты ⇒ стандартные отчеты ⇒ мониторинг ⇒ результаты проверки).

- Установлен ли https.

- Мусор в индексе (есть ли, если есть, то понять природу его появления и либо побороть причину, либо закрыть мусор от индекса через файл robots.txt).

- Коды ответов страниц сайта (есть ли битые ссылки (на 404 или 50х), редиректные ссылки (30х) и т.д., если есть, попытаться понять природу возникновения оных).

- Левые поддомены (можно проверить с помощью этого сервиса).

- Аффилиаты (с помощью инструментов этого сервиса).

- Корректные редиректы www или не-www (есть ли, 301-е ли, проверяем через этот сервис).

- Корректные редиректы страниц со слешем или без слеша на конце URL (есть ли, 301-е ли).

- rel=canonical (есть ли, корректны ли).

- meta-тег robots (проверяем, не закрыты ли важные страницы от индексации).

- robots.txt (закрыты ли от индексации служебные страницы, мусорные страницы, страницы фильтрации/сортировки и т.д.).

- sitemap.xml (есть ли, актуален ли, корректен ли).

- JS и CSS во внешних файлах (вынесены ли скрипты, дабы не утяжелять страницу, необходимо смотреть на всех шаблонах).

- Логические дубли (нет ли дублей вида «лестницы è из дерева» и «изделия из дерева è лестницы» и т.д.).

- Дубли товарные карточек (нормально ли генерируются урлы тов. карточек).

- url'ы (корректно ли генерируются, содержат ли кириллицу, заглавные буквы, подчеркивания, точки, пробелы и пр.).

- Перелинковка (может ли робот пройти на все страницы и т.д.).

- Хлебные крошки (есть ли, корректные ли, с микроразметкой ли).

- Относительные ссылки (все ссылки должны быть относительными).

- Возможность генерации новых страниц на основе существующих (например, страниц отзывов для товарных карточек).

- h1 (есть ли, на всех ли страницах, только один на странице).

- title (везде ли есть, нормальные ли, отсутствуют ли дубли).

- description (везде ли есть, нормальные ли, отсутствуют ли дубли).

- Теги заголовков h2 (корректно ли используются).

- Теги заголовков h3-h6 (корректно ли используются).

- Размер изображений (не очень ли тяжелые).

- Атрибуты alt для изображений (прописаны ли, корректно прописаны ли, не дублируются ли и т.д.).

- Ошибка 404 (отдает ли несуществующая страница 404, корректно ли отдает (без всяких редиректов), во всех ли случаях отдает и т.д., проверяем через этот сервис).

- Микроразметка товарной карточки (присутствует ли, есть ли в ней ошибки, везде ли есть, дублируется ли в формате JSON-LD и т.д., проверяем через этот сервис).

- Микроразметка Product на категориях (присутствует ли, есть ли в ней ошибки, везде ли есть, дублируется ли в формате JSON-LD и т.д., проверяем через этот сервис).

- Сгенерирован YML-файл для Яндекса.

- Сортировка и фильтрация через ajax (есть ли, корректно ли работает).

- Адаптация под мобильные устройства и планшет (есть ли, корректно ли работает).

- Отзывы (есть, нормально ли работают, имеют ли соответствующую микроразметку в форматах microdata и JSON-LD, проверяем через этот сервис).

- Микроразметка organization (есть ли везде, где надо, корректная ли, проверяем через этот сервис).

- Поиск по сайту (есть, живой ли, нормально ли функционирует).

- Иные ошибки (кодировка кривая, не работает корзина и т.д).

- Наличие кнопки обратного звонка (если, работает ли, нормально ли количество форм).

- Набор номера с телефона.

- Характеристики товаров (есть ли у всех товарных карточек).

- Характеристики товаров в превью (выводятся ли важные характеристики в превью карточки на категориях).

- Функционал подбора товара по параметрам (есть ли, корректно ли работает).

- Функционал сравнения в тематиках продажи техники (есть ли, корректно ли работает, генерирует ли ЧПУ, заголовки, title и т.д.).

- Страницы «Аналоги» для товарных карточек в тематиках продажи техники (есть ли, корректно ли работают, генерируют ли ЧПУ, заголовки, title и т.д.).

- Галерея (для запросов вида «%название категории% фото / в интерьере» и т.д.).

- У всех ли товаров имеются изображения (желательно несколько).

- Есть ли информация о доставке (страница доставки, информация на товарных карточках).

- Есть ли информация об оплате (страница оплата, информация на товарных карточках).

- Есть ли информация о гарантии для некоторых тематик (хедер или футер всех страниц, страница гарантии, информация на товарных карточках).

- Аккаунты в соцсетях (есть ли, живые ли, есть ли ссылки на сайте).

- Кнопки расшаривания по соцсетям (есть ли, работают ли).

Инструменты

- Bertal - сервис для проверки кодов ответа сайта.

- Проверка микроразметки - сервис по проверке микроразметки сайта.

- Проверка на поддомены - сервис по проверке поддоменов сайта.

- Arsenkin - список инструментов по проверке сайтов на SEO, в том числе на аффилиат.

- Оптимизация под мобильные - сервис для проверки оптимизации сайта под мобильные устройства.

- Проверка Robots.txt - сервис по проверке файлов robots.txt.

- Проверка Sitemap.xml - сервис по проверке файлов sitemap.xml.

Публикация ➔ TotalShiva