Прогнозирование трафика и выбор эффективных поисковых запросов

Какие задачи решает скоринг запросов?

- Низкая конкуренция

Небольшие вложения в рекламу и продвижение этих запросов рынком

- Запросы с растущим спросом

Поиск таких запросов – клад для информационных сайтов и коммерческих интернет-магазинов, работающих с большим количеством брендов и постоянно расширяющих свой ассортимент. Пример: американская торговая марка Under Armour. В 2016-2017 году спрос и конкуренция была по ней минимальна. Сегодня же Under Armour является одной из самых популярных мировых торговых марок.

- Поиск запросов, по которым нет агрегаторов и сложной коммерции в ТОП

Одна из актуальнейших задач сегодня. Если у вас интернет-магазин в популярной нише, значит каждый день вы теряете трафик за счет того, что вас выжимают из ТОП. Если вы хотите открыть агентство недвижимости, без скоринга вы не увидите ТОП даже с самыми крутыми SEO-специалистами. Но есть запросы, по которым нет агрегации и коммерческих гигантов, их необходимо просто найти.

- Прогнозирование трафика

Все прекрасно понимают, что SEO – самый масштабный и, в подавляющем большинстве случаев, самый рентабельный канал трафика. Но как посчитать вложения и возврат инвестиций на старте?

Решение от Ожгибесова – скоринг запросов и итерационное продвижение.

Действовать можно так:

- Собрать данные для исследования вашей тематики.

- Подготовить расшифровку для доменов.

- Получить данные по составу топа в вашей тематике.

- Получить данные по изменению URL у фраз на основании разных итераций вводных (недели, месяцы и т.д.).

- Выбрать запросы, у которых отсутствует необходимый тип расшифровки (например, агрегаторы) – и внедрить эту семантику.

- Выбрать запросы с минимальным присутствием по позициям необходимого типа расшифровки (например, агрегаторы) – и внедрить эту семантику.

- И только после получения топа по этим запросам – переходить к наиболее сложной семантике.

Необходимо заниматься поиском запросов в своей тематике хотя бы в течение месяца. Если вы собираете запросы один раз, то не сможете понять динамику и спрогнозировать – хорошая или плохая у них перспектива в выбранной тематике. Вы сможете дать только текущую позицию. Например, текущая позиция по Яндексу 65%, но за последние полгода он потерял около 10% коммерческих сайтов. Чтобы это видеть, нужно отслеживать изменения.

Дальше нужно подготовить расшифровку доменов. Это делается вручную. Один специалист может обработать 1500 доменов за сутки.

Затем сводим данные. Можно использовать два варианта инструментов:

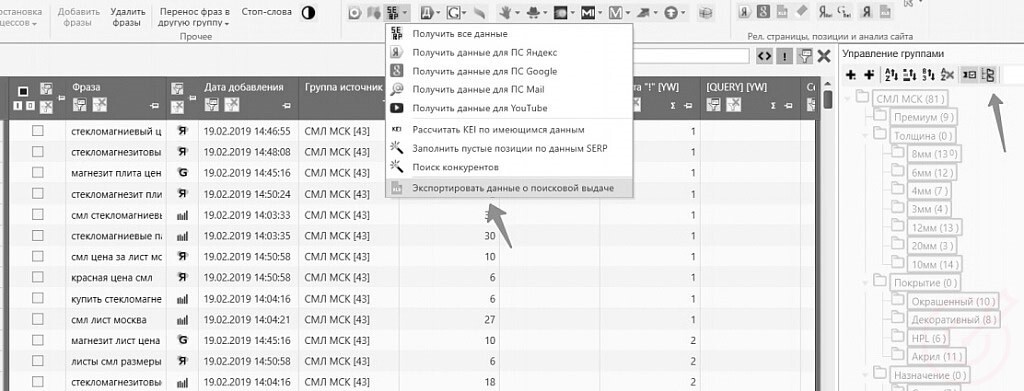

- Key Collector и XMLproxy (для Яндекса), XMLRiver для Google.

- Topvisor – инструмент Снимки выдачи.

Заниматься этим нужно как минимум четыре недели для каждой поисковой системы.

Для Яндекса разбираем на примере Key Collector. Берем файл семантики и делаем копии.

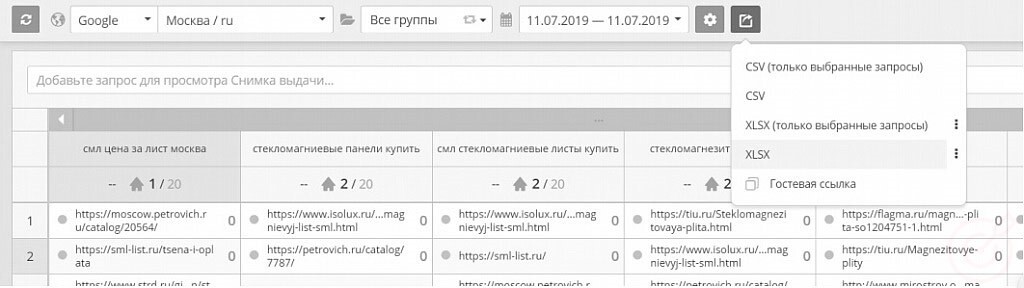

Для Google разбираем на примере Topvisor. Скачиваем файл из Topvisor по датам.

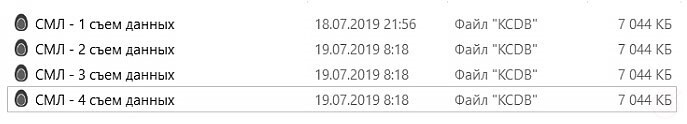

Открываем все итерации в KC, выгружаем данные поисковой выдачи в режиме Мульти-группы. Если вы снимали данные выдачи 4 раза, выгружаем по всем файлам.

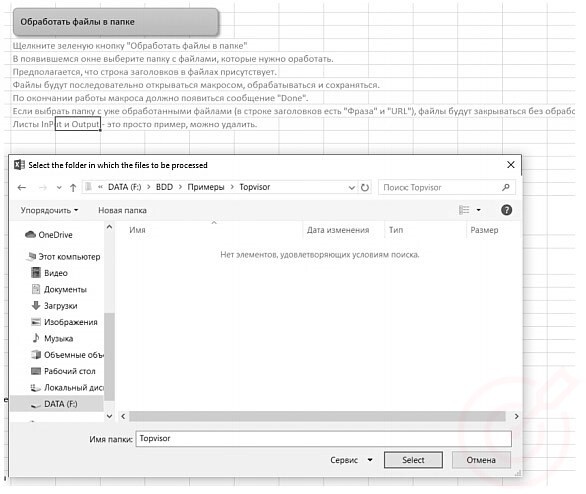

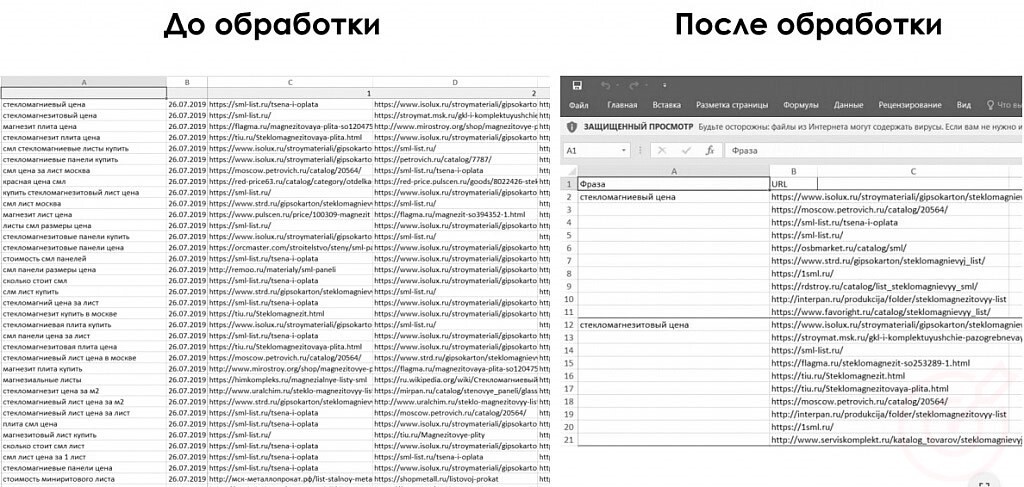

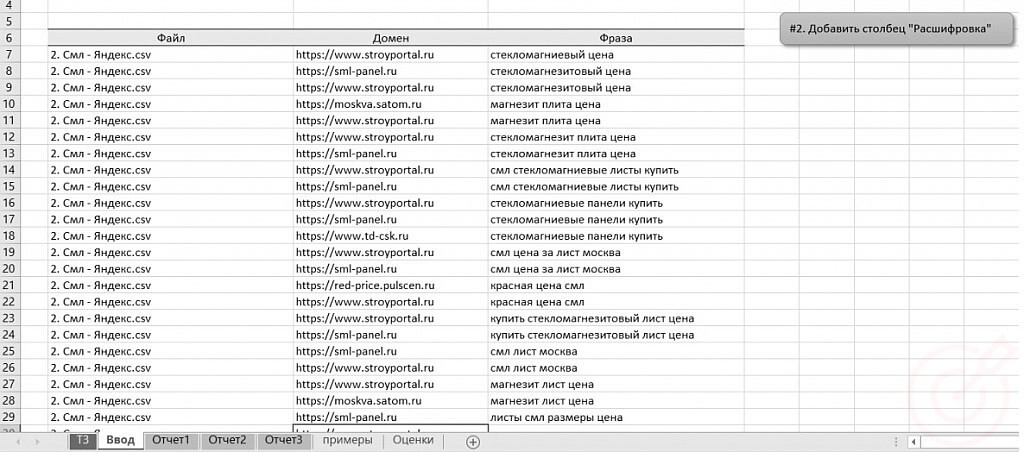

Файлы Topvisor отличаются от вида Key Collector, поэтому их нужно обработать, чтобы вид был 1. Для этого запускаем макрос для обработки данных в папке.

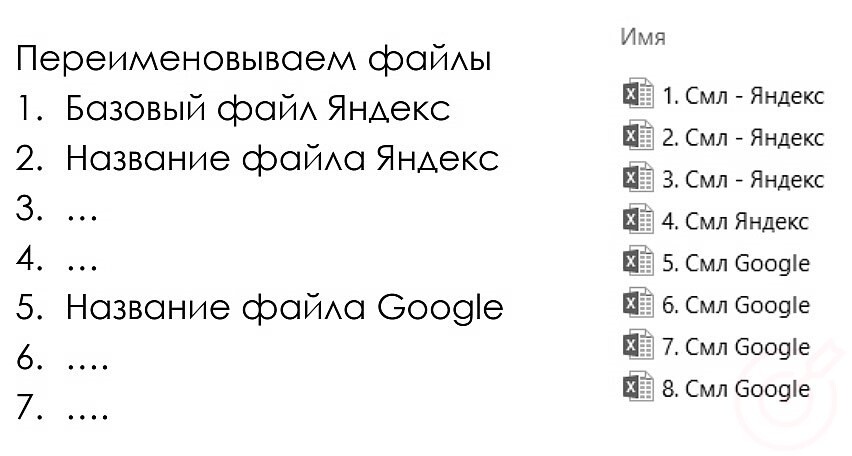

После сбора данных переименовываем их.

Яндекс – первый, Google – второй. Порядок для нашего макроса обязателен – по нему происходит обработка данных.

Из 1 базового файла нам необходимо получить домены из URL.

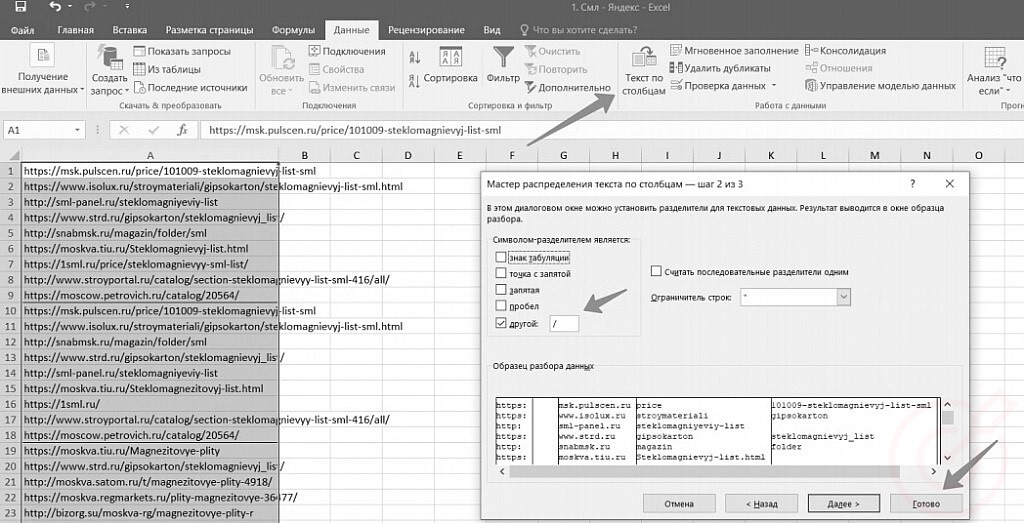

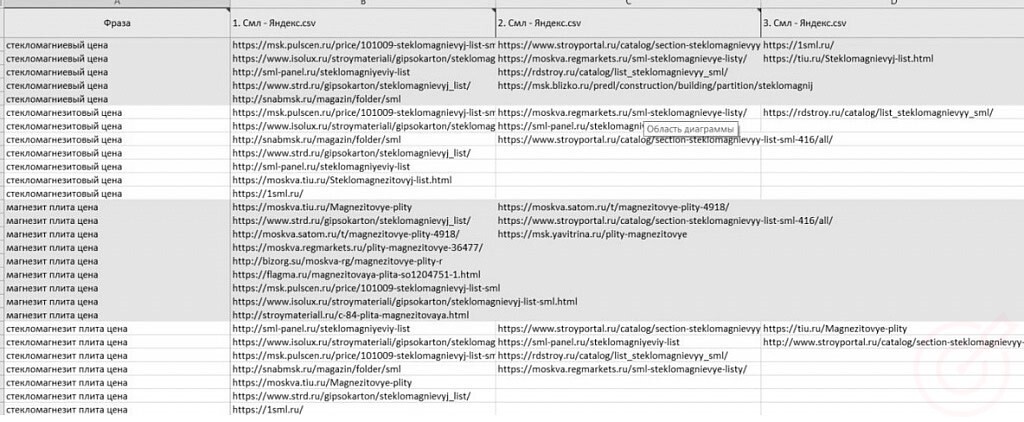

Далее нам нужна расшифровка по доменам. Копируем столбец URL в отдельный столбец и применяем «Текст по столбцам».

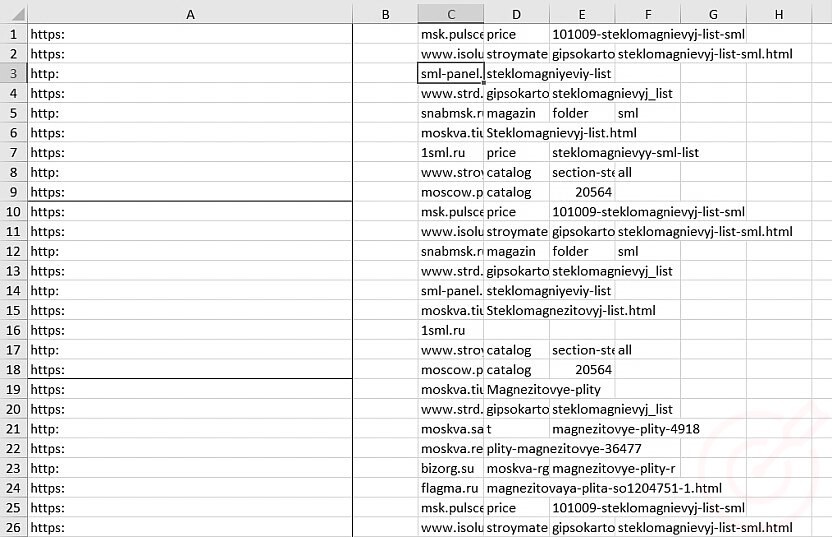

Получаем список:

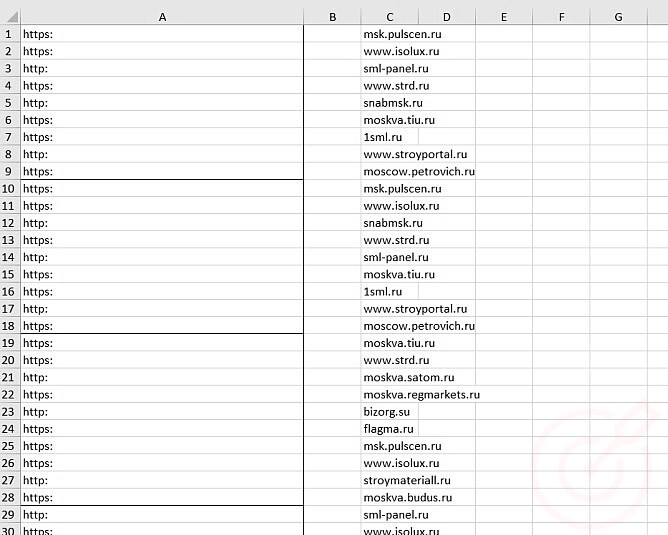

Удаляем все, начиная от столбца D, чтобы остался протокол и домен.

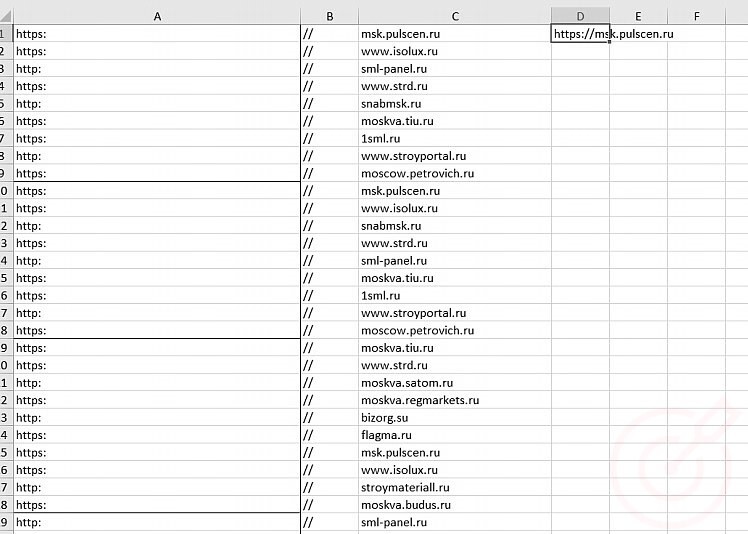

В столбец «B» вставляем «//» и протягиваем. В ячейке D1 пишем формулу =СЦЕПИТЬ(A1;B1;C1;) и протягиваем.

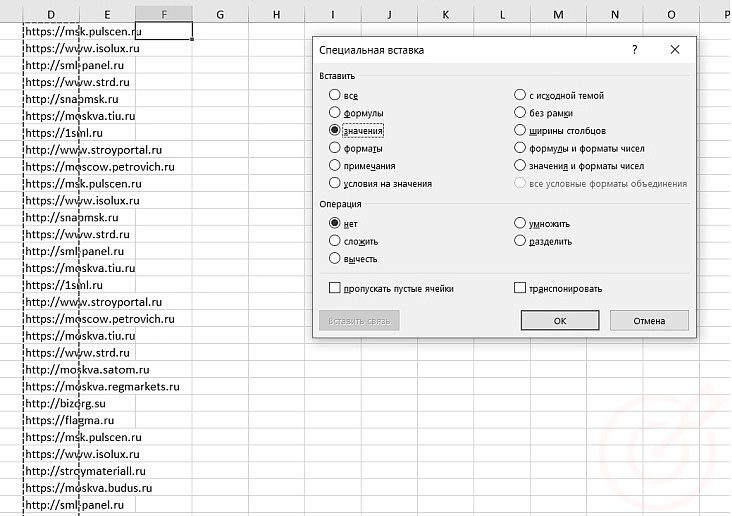

Копируем столбец D и используем специальную вставку, чтобы из формул получить данные.

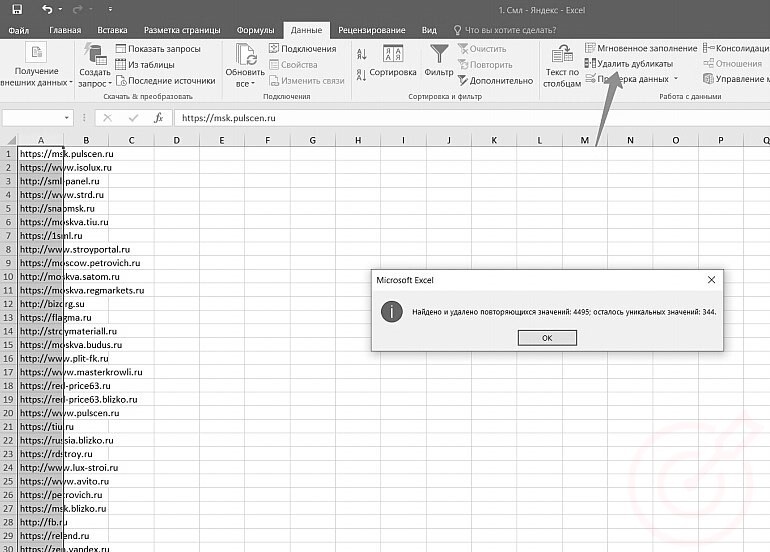

Выделяем весь столбец и удаляем дубликаты.

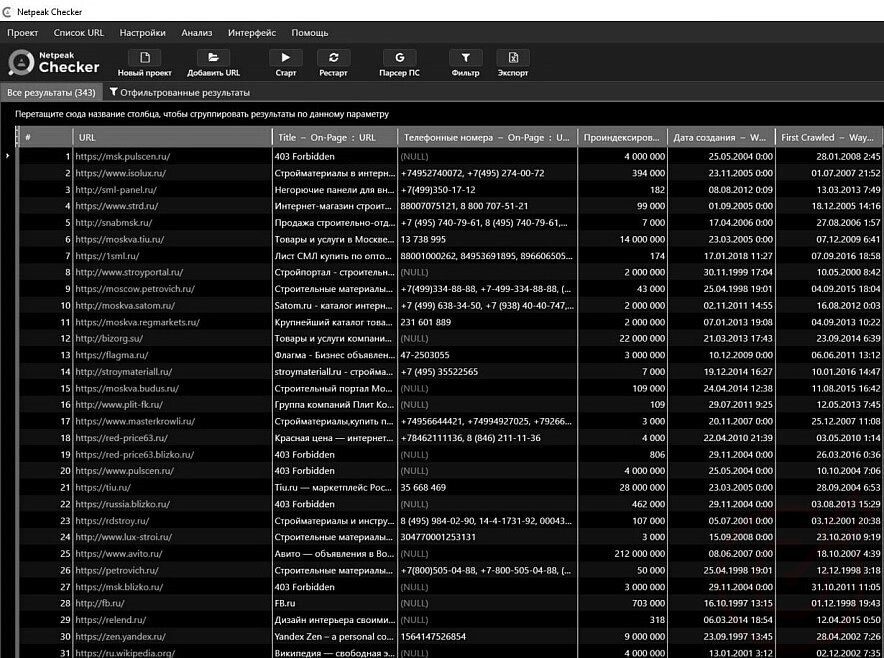

Полученные 344 домена вставляем в Netpeak Checker и снимаем следующие параметры:

- title;

- телефонные номера;

- проиндексированных URL в Яндексе;

- дата регистрации домена и дата первого сканирования веб-архивом.

Например, если у сайта коммерческий title, то несложно сделать вывод, что это коммерческий продукт.

Опционально проверяем трафик через SimilarWeb и количество фраз в ТОП-100 через Serpstat. Это поможет сориентироваться: если в вашей тематике у всех в ТОП-100 примерно 5000 фраз, а у какого-то сайта 30 000, то это явно агрегатор.

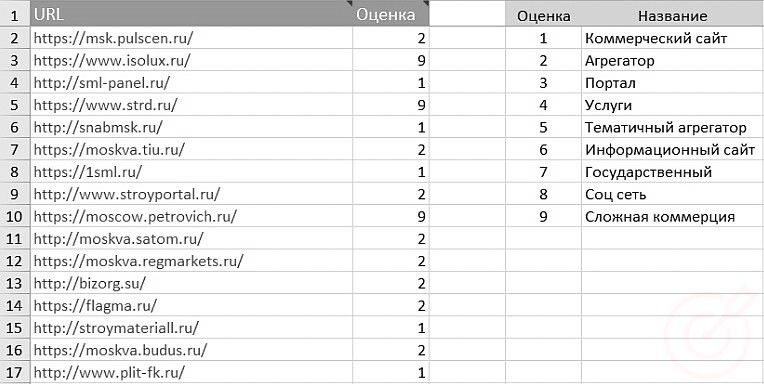

Полученные данные готовим в таком виде:

На основании полученных данных и ручного просмотра сайтов вам необходимо подготовить расшифровку и привести это в следующий вид:

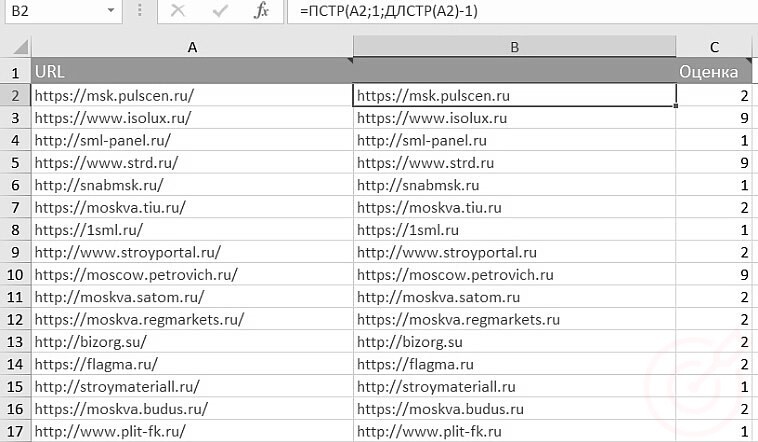

Checker выдает вам вид сайт https://url.ru/, нам необходимо убрать последний слеш, для этого используйте формулу =ПСТР(A2;1;ДЛСТР(A2)-1).

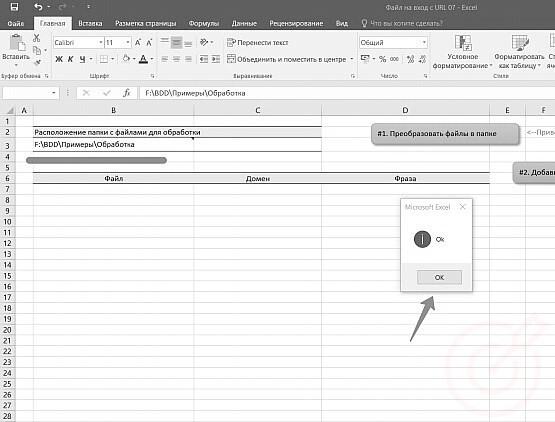

Переходим к макросу. В последний лист «Оценки» вставляем домены и расшифровку. Затем переходим в лист Ввод и выбираем папку с данными, которые мы подготовили. И нажимаем преобразовать. Если вы все правильно сделали, вы увидите «ОК».

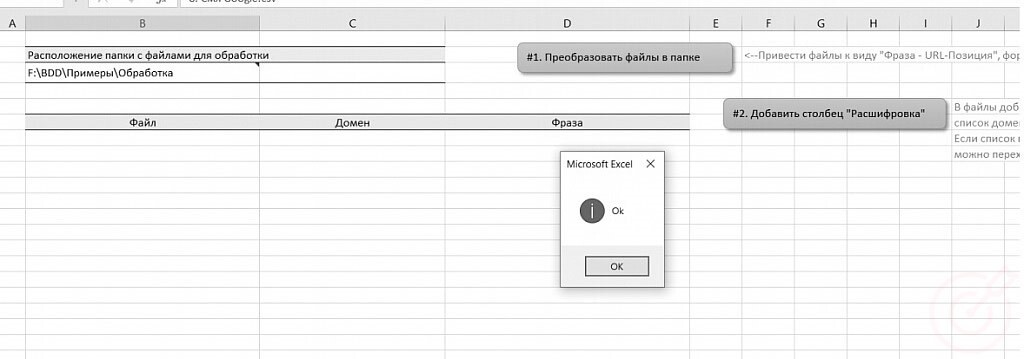

Нажимаем вторую кнопку. Макрос отдаст вам домены во всех файлов, для которых нет расшифровки. Повторяем процесс расшифровки.

Всего для этой тематики понадобилось расшифровать 796 доменов. В случае успеха при повторном нажатии кнопки, макрос выдаст сообщение ОК.

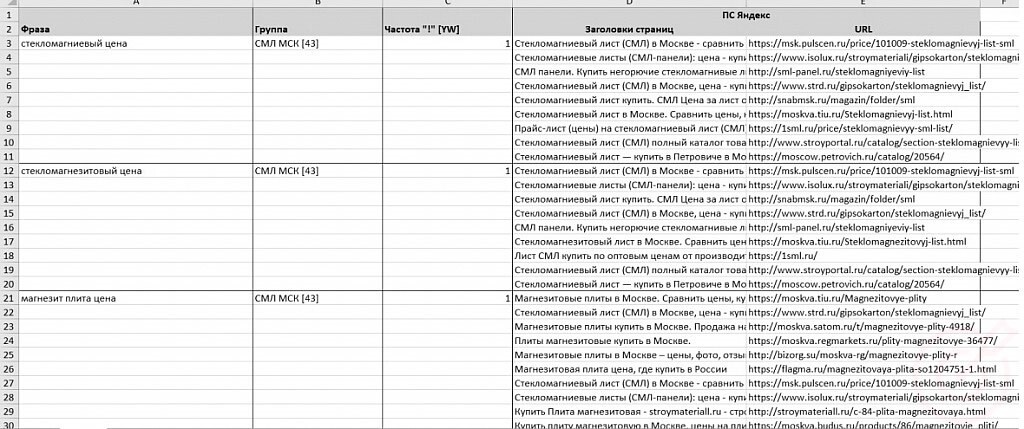

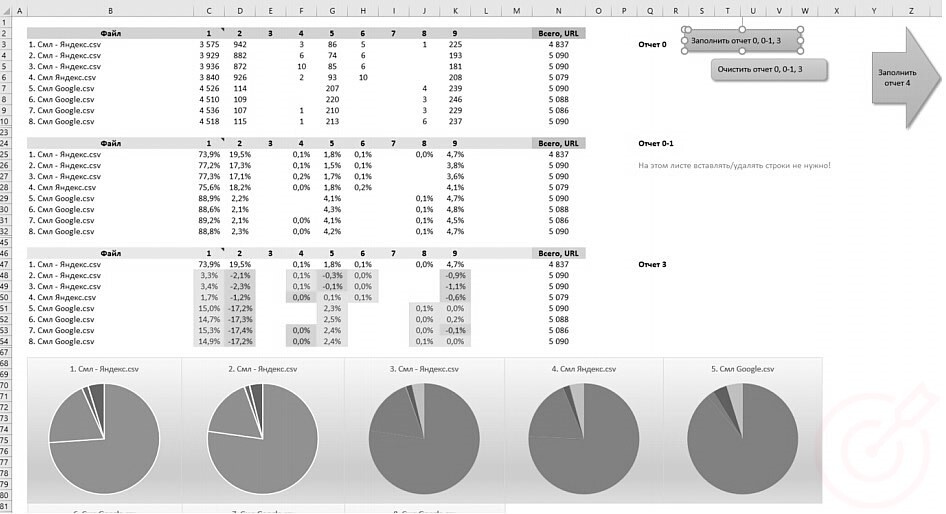

В итоге получаем полную аналитику по выдаче. Переходим на лист Отчет1 и нажимаем кнопку заполнить Отчет 0,0-1,3.

При нажатии на кнопку Заполнить Отчет 4, в листе Отчет 2 заполнятся данные об изменении URL с привязкой к фразам и файлам.

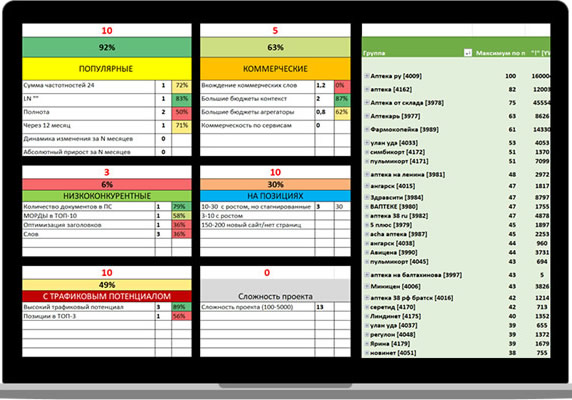

На третьем листе отчета – скоринг запросов.

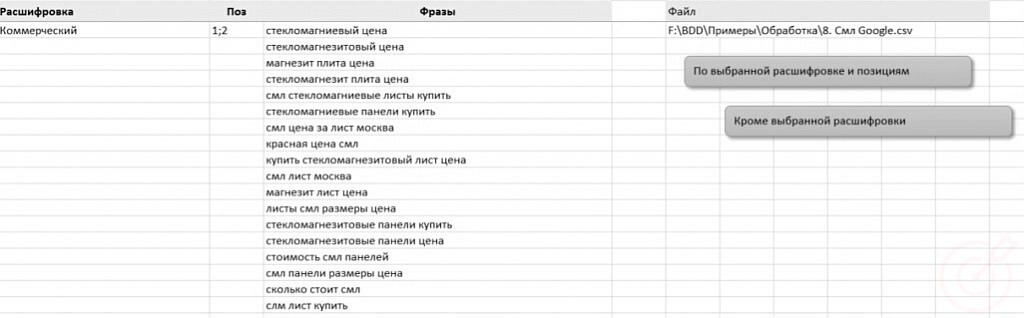

У макроса есть удобная функция «Кроме». После загрузки и обработки файла, программа покажет все запросы, по которым нет агрегации.

Например, мы взяли сегмент недвижимости. Всего 6000 запросов. Мы нашли 218 запросов без агрегации в Яндексе и 529 запросов в Google. Работайте именно с ними.

Есть запросы, по которым продвигать сайт легко, а есть те, по которым выдача полностью состоит из агрегаторов и продвинуться сложно. Лучше убрать эти запросы и приоретизировать продвижение. Эффективнее работать там, где вас не вытесняют.

Что же все-таки важно в SEO?

- Семантическое ядро и структура. Структура тоже имеет огромное значение. Чем больше страниц проиндексировано, тем лучше.

- Прогнозирование результата в SEO со старта работ.

- Юзабилити и коммерческие факторы. Делайте ваш сайт лучше.

- Принимайте решение на основание анализа и скоринга ТОПА (текстовый анализ, структура, линкбилдинг)

- Анализируйте запросы, ищите продающие. Не пытайтесь охватить всё сразу, используйте итерационное продвижение.

- Меняйте стратегию. Агрегаторы, сайты услуг и интернетмагазины не получиться двигать с одной стратегией

- Используйте мобильный трафик. Он с каждым днём забирает всё больше трафик у декстопа!

Публикация ➔ TotalShiva